He estado hablando con muchos profesionales sobre IA en los últimos meses. Hay algunos temas que surgen una y otra vez en estas conversaciones (impacto ambiental, infracciones de derechos de autor, malos resultados, etc.). Algunas personas no quieren usar IA en absoluto debido a estos problemas, especialmente en el Tercer Sector (trabajadores de organizaciones sin ánimo de lucro).

Estoy de acuerdo en que estos problemas existen, pero también creo que algunos problemas potenciales se han exagerado o se pueden reducir mucho si usamos la IA “adecuadamente”.

Analicemos los principales problemas sobre la IA*:

*️⃣ Nota

Nos centraremos principalmente en GenAI, ya que es el tipo de IA más popular y problemático actualmente. Sin embargo, es importante destacar que la IA no se limita a GenAI, LLM o ChatGPT. Existen muchos tipos de IA (algunos se han utilizado durante décadas y no presentan los mismos problemas). Quizás en unos años dejemos de usar GPT o LLM porque encontremos mejores soluciones de IA.

Malos resultados

Este es probablemente el punto más importante. Si la IA da malos resultados, todo lo demás no importa; nadie debería usarla (aunque no tuviera otros problemas).

Pero muchos estudios están mostrando excelentes resultados usando IA (y la mayoría de ellos usaban modelos de IA antiguos, ahora tenemos modelos mucho mejores):

- Los trabajadores que utilizan IA triplicaron su productividad (realizando en 30 minutos tareas que les habrían llevado alrededor de 90 minutos en promedio sin IA).

- El uso de IA generativa mejora la productividad de los empleados en un 66% en promedio .

- Consultores de primer nivel (BCG) utilizando IA finalizaron un 12,2% más de tareas y produjeron resultados de calidad un 40% superior que aquellos que no la utilizaron.

Otro dato: ChatGPT cuenta con más de 400 millones de usuarios activos . Por lo tanto, podemos suponer que millones de personas están obteniendo buenos resultados , al menos en algunas tareas (si solo vieran malos resultados, ya no lo usarían).

Además, muchas grandes empresas están invirtiendo miles de millones en IA, mucho más que en cualquier otra cosa antes (ni siquiera Internet), así que, a menos que pensemos que son simplemente tontos o quieren perder miles de millones sin ningún motivo, deberíamos asumir que están viendo un enorme potencial para aumentar los resultados, la productividad, la innovación, etc.

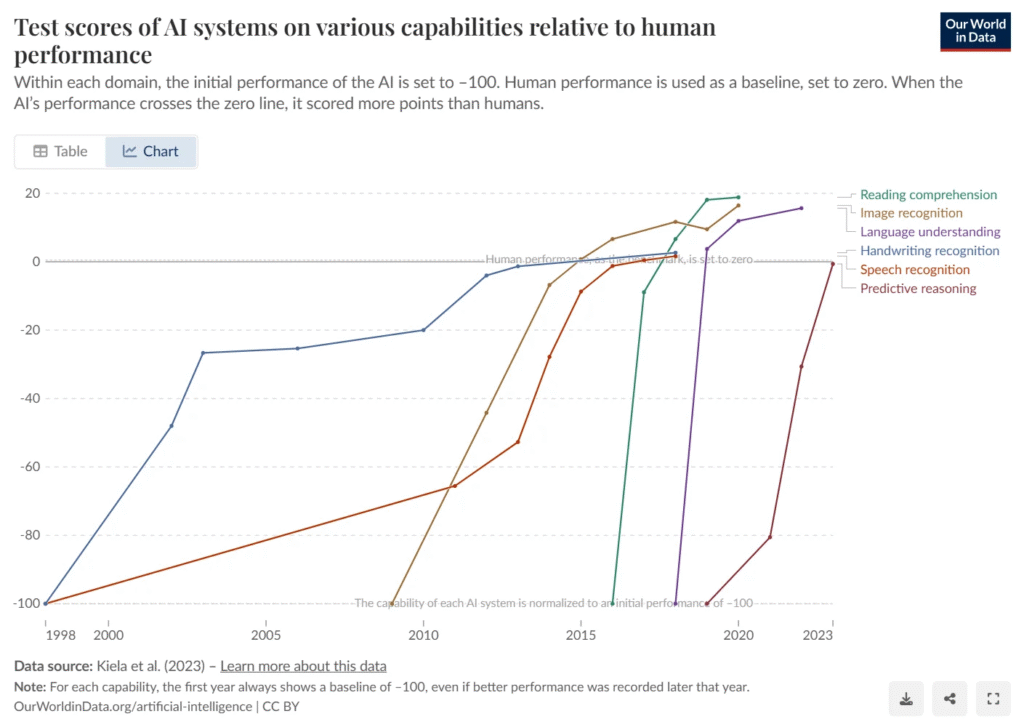

Sin duda, hay algunas tareas en las que la IA no ofrece buenos resultados (todavía). Pero también hay muchas tareas en las que la IA ya es mejor que los humanos (o al menos mucho más rápida y con resultados similares). No es fácil predecir de antemano quiénes serán los «ganadores», porque la IA no piensa ni se comporta como nosotros. Tenemos que probar diferentes tareas, herramientas y estímulos. Algunos expertos llaman a esto la «frontera irregular» de la IA.

Además, entre el 40 % y el 69 % de las organizaciones sin fines de lucro no han recibido capacitación formal en IA. Por lo tanto, es probable que muchas personas que reportan malos resultados no sepan usar las herramientas de IA correctamente (lo cual es normal, ya que son bastante nuevas y hay mucho que aprender). Probablemente no estén utilizando técnicas de «ingeniería rápida», funciones y configuraciones avanzadas, herramientas especializadas en lugar de ChatGPT para todo, etc. Por lo tanto, no se trata solo de un problema de herramientas, sino de personas (la mayoría de profesionales no ha recibido formación adecuada sobre IA).

Por ejemplo, algunas personas se quejan de que las respuestas de ChatGPT no siempre son fiables (y es cierto, a veces inventa o alucina información), pero eso no significa que la IA sea inútil. Hay que saber elegir y usar las herramientas correctamente (por ejemplo, usar herramientas de IA especializadas como Perplexity o Deep Research cuando se necesiten datos y fuentes fiables).

Existen miles de herramientas de IA disponibles actualmente, y también miles de posibles usos. Así que, si solo probaste ChatGPT para un par de tareas, has probado menos del 1% de las «oportunidades» de la IA. Quizá sea hora de explorar el 99% restante.

Impacto ambiental

La industria de la IA está en pleno crecimiento, lo que tiene un gran impacto ambiental . Sin duda. Los grandes centros de datos con miles de chips potentes consumen mucha energía (no 100 % renovable en la mayoría de los casos), agua (aunque esto podría cambiar en el futuro) y materiales.

Pero hacer un uso responsable de la IA probablemente no sea tan malo para el medio ambiente como mucha gente piensa.

Hay dos pasos principales con respecto a los modelos de IA: entrenarlos y ejecutarlos (también llamado “inferencia”).

1) Entrenar nuevos modelos de IA (especialmente los LLM de vanguardia) consume mucha energía, pero en el caso de los modelos populares, ese coste de entrenamiento se repartirá entre millones de usuarios. Además, en teoría, un modelo entrenado puede usarse indefinidamente (especialmente en el caso de los modelos de código abierto). Por lo tanto, el impacto por uso podría no ser muy significativo a largo plazo para algunos de los modelos de IA actuales.

Además, es probable que las empresas de IA sigan entrenando nuevos modelos (al menos durante algunos años) incluso si mucha gente se niega a usarlos. Entre otras cosas, porque se centran en ganar la carrera de la IA/IIA, no tanto en ganar dinero ahora mismo. Incluso hay empresas de IA con miles de millones de dólares en financiación que ni siquiera planean lanzar ningún producto público a corto plazo , porque se centran en entrenar una futura IIA (Superinteligencia Artificial), no en los usos o modelos actuales de la IA.

Algunos podrían argumentar que los costos de entrenamiento de IA no están directamente relacionados con nuestro uso individual. Si las empresas entrenarán esos modelos de todos modos (o ya los han entrenado), mejor que los usemos. No estoy seguro de si estoy de acuerdo con este razonamiento, pero creo que da que pensar.

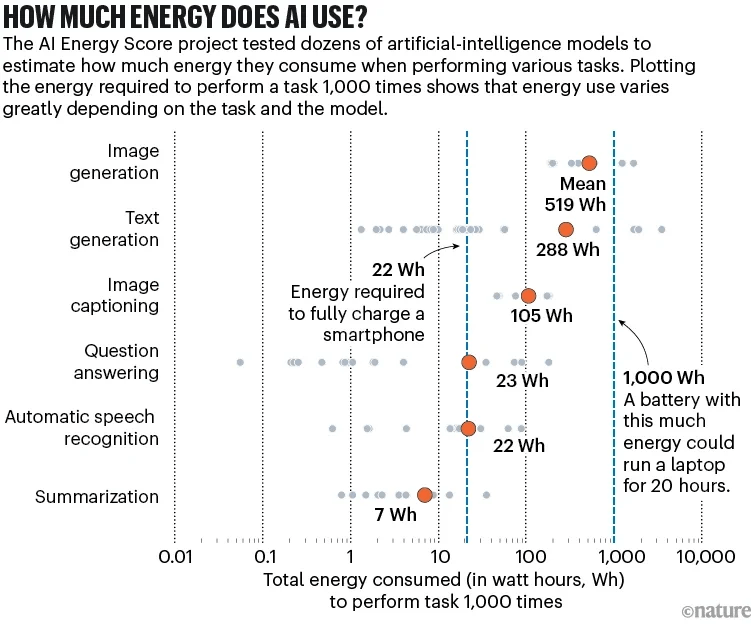

2) Ejecutar modelos de IA puede tener un gran costo de energía (si estamos haciendo tareas complejas como crear videos largos) o bastante pequeño (si estamos haciendo cosas simples como hacer preguntas cortas a modelos de texto pequeños). El consumo energético varía mucho según la herramienta y modelo que estén utilizando.

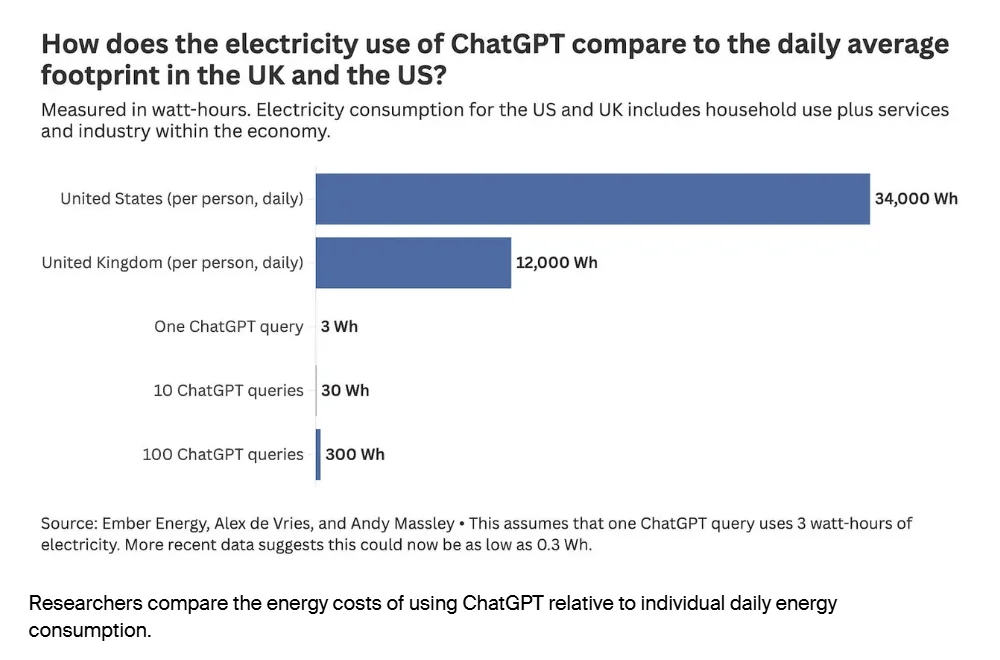

Según el MIT, la energía necesaria para tareas sencillas de un chatbot de IA puede ser de unos 114 julios por respuesta. Eso es muy poca energía. Tu portátil probablemente consume unos 3000 julios por minuto (26 veces más). Ver 1 hora de Netflix puede consumir más de 200 000 julios (1700 veces más). Tu hogar puede consumir unos 100 000 000 de julios al día (800 000 veces más). Así que pedir algunas cosas sencillas a los modelos de IA probablemente no haga casi ninguna diferencia en tu consumo energético total (en la mayoría de los casos, probablemente sea menos del 1 % de tu uso energético)

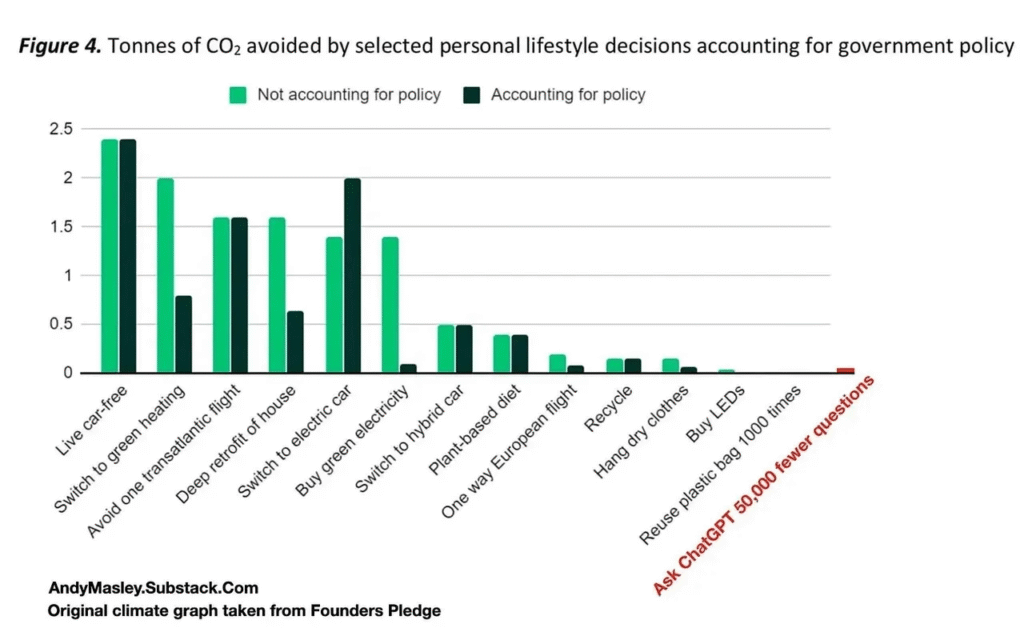

Una hora de jugar con tu PS5 o ver YouTube/Netflix podría tener más impacto que una hora usando ChatGPT. Y ChatGPT, obviamente, puede ser mucho más productivo. Así que, en lugar de rechazar el uso de IA, podría tener más impacto cambiar otras cosas en tu vida que pueden tener un impacto medioambiental 100 veces mayor .

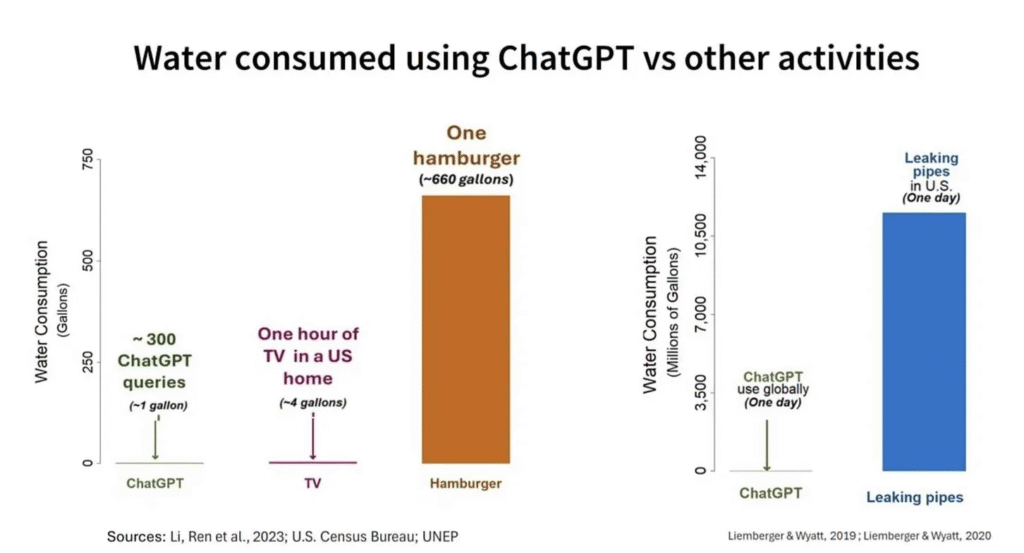

En cuanto al agua, la situación es bastante similar (usar ChatGPT para algunas consultas simples casi no tiene impacto en comparación con otras rutinas como comer una hamburguesa).

Usar IA puede incluso ahorrar energía en algunos casos . Por ejemplo, si obtienes un buen resultado de un chatbot de IA en segundos, en lugar de usar tu portátil durante 20 minutos para obtener lo mismo manualmente (sin IA).

Además, algunos expertos argumentan que la IA podría ayudarnos a reducir las emisiones globales mundiales en la próxima década (al acelerar la innovación, optimizar sistemas complejos en industrias clave, etc.). Pero de momento esto se basa solo en proyecciones y no está garantizado en absoluto.

Es difícil calcular el impacto ambiental exacto del uso de IA. No existen muchos datos fiables y existen decenas de variables (qué indicador y modelo se utiliza, si se utiliza IA en la nube o un modelo instalado en el propio ordenador, si se incluye el coste energético del entrenamiento de IA en el uso individual, qué solución alternativa a la IA se utilizaría para esas tareas, si los resultados de su trabajo podrían contribuir al medio ambiente, etc.).

Pero creo que podemos extraer tres aprendizajes principales:

1) Deberíamos considerar el impacto ambiental de los diferentes usos de la IA e intentar usarla solo cuando el impacto positivo (en la sociedad, nuestras organizaciones o en nosotros mismos) sea mayor que el coste energético . Por ejemplo, probablemente no deberíamos crear vídeos de IA para bromas u otros temas irrelevantes (alto coste energético y cero impacto positivo), pero si encontramos tareas sencillas de IA que nos ahorren mucho tiempo o mejoren nuestros resultados, creo que deberíamos intentarlo (bajo coste energético e impacto positivo en la sociedad).

2) Deberíamos aprender más sobre IA, para poder usarla de manera más eficiente (aprender “ingeniería rápida” para evitar gastar tiempo y energía en obtener resultados mediocres, evitar usar modelos de IA complejos para tareas fáciles, compartir aprendizajes y ganancias con nuestros colegas en lugar de hacer todo el ensayo y error nosotros mismos, etc.).

3) Si quieres minimizar tu impacto ambiental, probablemente deberías probar a instalar modelos de IA de código abierto en tu ordenador (sobre todo si tienes uno de esos nuevos portátiles que son energéticamente eficientes y compatibles con cargas de trabajo de IA: MacBook M3-M4, PC Copilot+, etc.). Estos modelos de IA de código abierto son suficientes para muchas tareas e incluso puedes ahorrar energía en algunos casos (en comparación con no usar IA y dedicar muchas horas al trabajo manual en el ordenador). Además, pueden ofrecer ventajas en materia de privacidad y seguridad (ya que no compartes información con herramientas de terceros ni servidores en la nube).

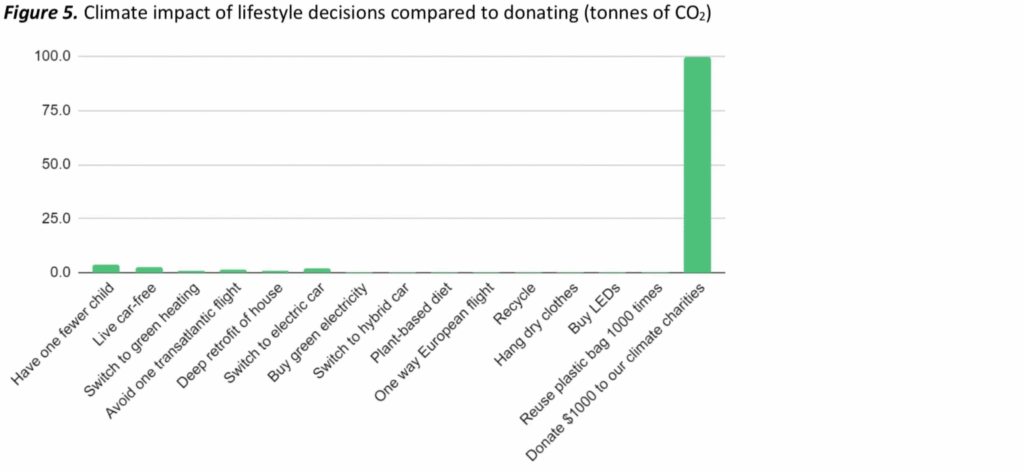

4) Si aún así te sientes mal, quizás podrías donar a una organización ambiental sin ánimo de lucro o compensar las emisiones de carbono.

Derechos de autor

Los modelos de IA (especialmente los LLM) se entrenan con cantidades masivas de datos y contenido. La mayoría de las empresas de IA no son muy transparentes sobre el contenido que utilizan exactamente, pero, al parecer, podemos asumir que una parte significativa está protegida por derechos de autor.

Existe un gran debate en torno a esto (incluyendo numerosos casos judiciales). Algunos afirman que constituye una grave infracción de derechos de autor. Otros argumentan que entrenar un modelo de IA con contenido protegido por derechos de autor constituye «uso legítimo», ya que se acerca más a aprender e inspirarse en otros creadores (como hacen constantemente los artistas y creadores humanos) que a copiar contenido específico directamente.

De todos modos, creo que la mayoría de nosotros entendemos por qué muchos creadores están enojados con las empresas de IA que usan su contenido y no dan nada a cambio.

Existen algunas soluciones para los creadores que no quieren que su contenido se incluya en el entrenamiento de IA (bloquear los scrapers de IA con robots.txt y otras herramientas , usar herramientas de protección como Glaze en sus obras, etc.). Pero incluso si estas soluciones funcionaran a la perfección, no recibir ninguna compensación no es una buena solución para muchos artistas y creadores (algunos ganan mucho menos que antes de la era de la IA).

Como usuarios, podemos priorizar el uso de modelos de IA entrenados éticamente (que utilizan contenido de dominio público o con licencia). Existen algunos (especialmente para la generación de imágenes y audio), como:

- Shutterstock AI : generador de imágenes de IA que garantiza una compensación justa por las contribuciones de los artistas al modelo de capacitación.

- Blunge.ai : generador de imágenes de IA que evita el robo de arte generado por IA.

- Modelos certificados por la organización sin fines de lucro Fairly Trained .

Hasta donde yo sé, ninguna de las grandes herramientas de IA (ChatGPT, Google Gemini, Claude, etc.) puede considerarse entrenada éticamente en este momento.

Si quieres usar esas herramientas de IA y, al mismo tiempo, apoyar a los creadores, podrías ofrecerles algún tipo de «compensación» comprándoles algo cada mes (arte, productos digitales, membresías, servicios, etc.) o donando a artistas o asociaciones. Sería algo similar a las compensaciones de carbono, pero para los creadores afectados por la IA.

Espero que la industria de la IA encuentre una solución mejor (tal vez obligada por leyes o decisiones judiciales), pero mientras tanto…

Problemas de privacidad y seguridad

No mucha gente me lo ha comentado, pero creo que es importante. Algunas organizaciones suben muchos archivos (incluso sus discos duros completos) a herramientas de IA sin tener cuidado.

La mayoría de las herramientas de IA son probablemente bastante seguras, pero casi cualquier cosa en línea puede ser hackeada. También existen otros posibles problemas de privacidad y seguridad relacionados con el uso de la IA (acceso no autorizado a ciertos mensajes o archivos a través de la IA, exfiltración de datos mediante agentes, etc.).

Además, algunas herramientas de IA se reservan el derecho de entrenar sus modelos con sus mensajes/información , pero generalmente tienen una opción para desactivar esto y/o no lo hacen en absoluto en cuentas pagas y uso de API.

Creo que todas las organizaciones deberían dar formación a su personal para mitigar estos riesgos.

Decirle a la gente que no use IA no funciona. Alrededor del 35% de las personas ocultan el uso de IA a sus organizaciones o empleadores. Por lo tanto, incluso si su organización prohíbe el uso de IA, los riesgos seguirán existiendo (o incluso aumentarán, ya que no pueden compartir sus preocupaciones, consejos de seguridad, etc.).

Muchos de estos riesgos se pueden evitar si simplemente no proporcionamos información confidencial a la IA (hay muchos usos de la IA que no requieren esa información).

Si necesita usar información confidencial, quizá le convenga usar modelos de IA de código abierto instalados en su ordenador (p. ej., Ollama o LM Studio) en lugar de los servicios en la nube (p. ej., ChatGPT). O, al menos, borre los archivos y conversaciones confidenciales de esos servicios de IA en la nube inmediatamente después de finalizarlos.

Impacto en la sociedad (empleos, creatividad, pensamiento crítico, desinformación, sesgos…)

Existen muchas incertidumbres en el futuro, pero también hay algunas cosas que no podemos dar por sentado:

1) La IA transformará el mercado laboral. Cambiará, eliminará y creará empleos. Los profesionales que no se adapten a los cambios podrían tener dificultades para mantener y encontrar trabajo en pocos años. Los profesionales que se adapten probablemente prosperarán (al parecer, ya existe una prima salarial del 56% para las habilidades de IA). Si logramos la Superinteligencia Artificial (una IA superior a los humanos en la mayoría de las tareas, lo que según muchos expertos podría suceder en pocos años), probablemente conducirá a la transformación más profunda del mercado laboral jamás vista.

2) La IA tendrá efectos positivos y negativos en la sociedad. Es lo mismo que ya ha ocurrido con cada nueva tecnología poderosa: internet, teléfonos inteligentes, redes sociales, etc. El impacto depende de cómo usemos estas potentes herramientas. Por ejemplo, la IA puede hacer que los estudiantes sean más perezosos, pero también puede mejorar su rendimiento académico y su pensamiento complejo. También puede abrir oportunidades que eran imposibles sin la IA (como tener tutores ilimitados para guiar a cada estudiante individualmente, en cualquier parte del mundo y prácticamente gratis).

3) No hay vuelta atrás: vivimos en un mundo de IA. Los beneficios potenciales de la superinteligencia artificial son demasiado altos, por lo que las grandes empresas y gobiernos seguirán impulsando su desarrollo. Incluso si la presión social logra detener el uso o desarrollo de la IA en un país, el resto continuará la carrera. E incluso si todos los países deciden prohibir el desarrollo de la IA o si todas las empresas de IA quiebran (lo cual es prácticamente imposible), ya existen docenas de excelentes modelos de código abierto que podemos instalar en nuestros ordenadores y usar gratuitamente para siempre. La IA nunca desaparecerá.

Así que éticamente tienes básicamente dos opciones:

A) Puedes negarte a usar cualquier IA. Esto tendría un impacto muy pequeño en la sociedad: Millones de personas seguirán usando la IA (incluidos los actores maliciosos), las empresas seguirán entrenando nuevos modelos, etc.

Y podría tener un impacto muy negativo en tu vida: Podrías quedarte sin empleo dentro de pocos años. Es muy probable que lleguemos al punto en que negarse a usar IA sea como negarse a usar internet o las redes sociales en el trabajo, solo porque estas tecnologías tienen algunos efectos negativos en la sociedad. Muchas organizaciones probablemente lo considerarán demasiado extremo (y negativo para sus resultados e impacto), por lo que contratarán a otra persona.

B) Puedes usar ciertas herramientas de IA de forma que encajen con tus principios y tengan un impacto positivo en la sociedad. Aprende a usar las herramientas de IA de forma responsable para generar efectos positivos (aumentar tu creatividad, productividad, impacto social, etc.) y reducir los efectos negativos (utiliza modelos y herramientas energéticamente eficientes, intenta usar la IA para reducir sesgos y desinformación, etc.).

Al mismo tiempo que aprovechas la IA para «hacer el bien» a nivel personal, puedes presionar a los gobernantes para que tomen medidas a nivel global (prohibir ciertos modelos y usos de IA de alto riesgo, redistribuir mejor los beneficios generados por IA y automatización, proteger los derechos de artistas y otros colectivos afectados, etc.). Esto puede ser mucho más efectivo que simplemente negarte a usar la IA.

Conclusion

La IA es poderosa, pero es solo una herramienta más. Debemos ser conscientes y cuidadosos al usarla, pero algunos usos de la IA pueden tener un efecto muy positivo (beneficios que superan con creces los riesgos y desventajas). Negarte a usar cualquier tipo de IA puede perjudicar más que beneficiar a tu organización sin fines de lucro y a tu impacto positivo en el mundo.

La IA nos brinda la oportunidad de aumentar nuestro impacto social. Podemos aprovechar esta oportunidad o ignorarla, pero la IA transformará nuestra sociedad de todas formas.

Siguientes pasos

Obtén nuevos “Superpoderes de IA”. Mejora resultados, ahorra tiempo y evita riesgos.

Recibe ayuda experta. ¿Tienes preguntas sobre IA? ¡Solicita una consulta gratuita!