¿Qué es un test A/B?

Los tests A/B permiten probar simultáneamente 2 versiones (o más) de una página web, para comprobar cuál consigue realmente mejores resultados (más donaciones, suscriptores o lo que se busque). Puede ser un cambio en una página concreta de la web (por ejemplo, un texto diferente) o algo que afecte a la web en general (por ejemplo, un cambio de diseño).

Normalmente se muestra la versión A al 50% de los visitantes de esa página y la versión B al 50% restante.

Se espera un tiempo para recabar suficientes datos (dependiendo del volumen de visitantes puede ser desde 1 semana hasta varios meses) y si todo va bien al final podremos saber de manera estadísticamente fiable qué opción da mejores resultados y con qué diferencia (por ejemplo, la versión B consigue un 30% más de donaciones que la versión A, con un 95% de confianza).

Son la única manera totalmente fiable de saber el impacto que tiene un cambio concreto, porque si se mete el cambio directamente (sin test A/B) los resultados se pueden tergiversar.

También se puede hacer para emails, anuncios y otros contenidos online.

Requisitos y recomendaciones para realizar tests A/B

Tener suficiente tráfico y conversiones

Los tests A/B necesitan bastantes datos para resultar estadísticamente fiables. Si realizas un tests con pocos usuarios, los resultados que tendrás serían muy poco fiables y te pueden llevar a engaño.

Para poder realizar un test A/B sin tener que esperar muchos meses para ver resultados fiables, es necesario tener bastantes usuarios (visitantes en las páginas que sean objeto del test A/B) y bastantes conversiones (que muchos de esos visitantes completen el objetivo que va a ser la referencia para determinar la versión ganadora).

Existen calculadoras para saber cuántos visitantes o cuánto tiempo necesitaremos en función del porcentaje de conversión actual y las versiones que queramos probar (se pueden probar más de 2 versiones simultáneamente, pero cada versión que añadamos hará que tengamos que esperar más tiempo para tener resultados fiables):

- Calculadora de duración del test (y otra distinta).

- Calculadora de tamaño de muestra (nº de visitantes necesarios) (y otra distinta).

Si las calculadoras te indican que necesitarías muchos más visitantes y conversiones de los que tienes actualmente para finalizar el test en pocas semanas, probablemente los tests A/B no deban ser la prioridad para tu organización. Mira la sección de “Alternativas a tests A/B” para ver en qué cosas te puedes concentrar en su lugar.

Detectar primero lo que falla

Si te pones a probar cosas casi al azar, sin tener claro qué estás intentando arreglar, es poco probable que consigas grandes resultados.

Tienes muchas más posibilidades de conseguir grandes mejoras si los tests se basan en problemas y oportunidades de mejora detectadas, como por ejemplo:

- Un informe de Google Analytics que indica en qué paso del proceso de donación se están perdiendo a más potenciales donantes

- Una encuesta a donantes o visitantes de la web donde te indican qué echan en falta en tu Web o en tu página de donación.

- Críticas recurrentes que habéis recibido en emails, chats online, redes sociales, eventos…

Priorizar según recursos e impacto potencial

Es importante analizar qué tests son más prioritarios para no perder tu tiempo y energía con tests que no van a marcar la diferencia.

Realizar tests no implica grandes inversiones de dinero, pero sí existe un coste de oportunidad, es decir, el coste de perder el tiempo con un experimento poco relevante cuando podrías estar realizando en su lugar un experimento que multiplique las donaciones de tu organización.

Técnicamente podrías lanzar decenas de tests simultáneos en una misma Web, pero hay bastantes posibilidades de que algunos de ellos se afecten mutuamente y acaben tergiversando los resultados. Por ello, es recomendable no realizar simultáneamente tests que pueda tener alguna influencia entre sí.

Por otro lado, cada experimento suele necesitar varias semanas para dar resultados estadísticamente fiables (entre 2 y 8 semanas normalmente), por lo que sólo se pueden lanzar un número limitado de experimentos al mes.

Por eso es importante hacer un listado de ideas para tests y priorizarlas según dos criterios básicos:

- Los recursos que requiere el test (si costará mucho tiempo y/o dinero prepararlo)

- El impacto potencial del test (si es previsible que el cambio que queremos probar produzca un gran aumento de donaciones o no)

Por tanto, normalmente es mejor empezar por cambios sencillos que puedan tener un gran impacto, como por ejemplo cambiar los argumentos y fotos que muestras en la página de donación.

Elige el tipo de experimento adecuado

Se puede hablar de dos grandes tipos de experimentos:

A) Test A/B

Se presentan dos opciones distintas e independientes al usuario (dos páginas web, dos mensajes de correo electrónico, dos anuncios, etc.) y se mide cuál de ellas proporciona mejores resultados.

Esta es la forma más sencilla de prueba, ya que es fácil de preparar, fácil de entender y tiene menores requerimientos técnicos (existen varias herramientas gratuitas para hacer tests A/B, requieren menos datos para llegar a resultados estadísticamente fiables, etc.).

Una variante son los tests A/B/n, que son exactamente lo mismo pero con más de dos opciones (“n” opciones). Debe tenerse en cuenta que cuántas más opciones queramos probar, más tiempo nos costará llegar a resultados fiables.

B) Test Multivariante

Es un tipo de experimento más complejo, encaminado a determinar el efecto por separado de distintas variables de una página.

Por ejemplo, podemos querer optimizar una página concreta, para lo que queremos probar al mismo tiempo 3 tipos de botones, 3 imágenes y 3 títulos distintos, para ver cuáles funcionan mejor. En lugar de tener que preparar una página con cada una de las combinaciones posibles (27 en este caso), podemos simplemente indicar al software de tests multivariante que queremos probar esos 9 elementos y su sistema se encargará del resto.

Los irá intercambiando de forma automática y registrando los resultados obtenidos por cada variante. Al final, te presentará un informe detallado donde te indicará por separado el efecto de cada elemento (por ejemplo, el botón rojo ha aumentado un 10% las conversiones, el azul las ha bajado un 3%, el título 1 las ha aumentado un 15%, etc.).

Además de que normalmente requieren software más complejo y caro, el gran problema de los tests multivariante es que exigen recabar mucha más información (más visitas y conversiones) para llegar a resultados estadísticamente fiables, al tener que probar muchas más combinaciones distintas. Eso hace que este tipo de experimentos estén indicados principalmente para webs con millones de visitas. En webs con pocas visitas podrían tardarse incluso años en alcanzar resultados fiables.

Elige la métrica adecuada

Además del tipo de experimento, tenemos que decidir en función de qué variable vamos a determinar la versión ganadora. En cada caso será una diferente: nº de donaciones, cantidad donada total, número de visitas a la página de donación, nº de personas interesadas en ser voluntarios, nº de suscriptores, nº de “shares” en redes sociales…

En general se debe intentar tomar una métrica que esté lo más cercana al objetivo final que buscamos (en este caso sería normalmente aumentar el nº y la cantidad total de donaciones).

Sin embargo, hay al menos dos situaciones en las que esto no es aconsejable:

- Si hay muchas donaciones que se producen offline (y por tanto no van a ser registradas por Google Analytics ni el sistema de los tests A/B).

- Si el nº de donaciones mensuales a tu organización es reducido. Es esta situación, resultaría prácticamente imposible llegar a resultados estadísticamente fiables si tomas las donaciones completadas como métrica de los experimentos (pocas donaciones = pocos datos = poca fiabilidad).

En estos casos, la mejor solución suele ser establecer como métrica algo que suceda en los pasos iniciales del proceso de donación y que sea más fácil de medir online (como las visitas a la página de donación, si es que estamos midiendo el impacto de un cambio que está fuera de esa página), para tener muchos datos rápidamente con los que poder ir tomando decisiones.

No acabes los experimentos demasiado pronto

Si al principio una de las alternativas consigue resultados mucho mejores que el original, las estadísticas rápidamente te indicarán que tiene un elevado % de confianza estadística. Sin embargo, puede ser una coincidencia, que sólo podrás verificar si dejas algo más de tiempo para conseguir más datos.

Por ejemplo, si tiras una moneda, lo normal es que salga cara el 50% de las veces y cruz el otro 50%. Sin embargo, puede darse la casualidad de que tires la moneda 10 veces y 8 veces salga cara. Si te dejarás llevar por esos resultados iniciales y pararas el experimento en ese punto, te llevarías una conclusión completamente errónea.

Por ello, es recomendable dejar suficiente tiempo para tener una muestra realmente representativa (en experimentos web, se suele recomendar un mínimo de dos semanas).

Incluso aunque tu Web tenga mucho tráfico, es recomendable dejar los tests al menos una semana porque a veces los resultados son distintos según el día de la semana (diferentes usuarios/comportamientos en fines de semana por ejemplo).

Desconfía de los experimentos realizados en circunstancias anormales

Para que los resultados de un experimento sean realmente fiables a largo plazo, el experimento tiene que haberse realizado en circunstancias similares a las que se van a encontrar después.

Si se realiza durante una temporada con circunstancias anormales, éstas pueden tergiversar los resultados y llevarnos a engaño. Por ejemplo, supón que tienes una tienda de corbatas. Normalmente tus clientes son gente de negocios, pero durante las navidades los principales compradores son familiares que buscan un regalo.

Por ejemplo si haces una prueba en las últimas semanas del año (cuando suele donar más gente y por razones diferentes al resto del año), puede que la versión ganadora no sea la mejor para el resto del año.

También te puede engañar si haces el test cuando tu Web está recibiendo muchos visitantes inusuales (por ejemplo, por haber aparecido tu organización en prensa), que puede que no se comporten igual que los visitantes usuales (que son los importantes a largo plazo).

Puedes optar por directamente no realizar experimentos en circunstancias anormales (navidades o vacaciones de verano, épocas de lanzamiento de nuevos productos, momentos en que se reciba mucho tráfico anormal por presencia en medios de comunicación o campañas virales, etc.) o dejar correr esos experimentos durante más tiempo de lo habitual (fuera de la “temporada anormal”).

De lo contrario, este tipo de experimentos te pueden llevar a conclusiones que no son aplicables en circunstancias normales.

Pon los resultados en cuarentena

Este es un paso que no verás en la mayoría de guías, pero que resulta básico para conseguir los mejores resultados posibles a largo plazo.

Una vez has finalizado un experimento, lo normal es que las mejoras que se han visto durante la prueba se vean igualmente una vez implementados esos cambios en la “realidad”. Esto ocurre en la mayoría de casos, pero no siempre es así.

Podemos encontrarnos con que los resultados a largo plazo no coinciden con los del experimento por diferentes razones:

- Experimentos realizados incorrectamente o en circunstancias que distorsionan los resultados.

- Aparición de variables que no existían durante el experimento.

- Efecto novedad: versiones que funcionan bien al principio sólo por el hecho de ser nuevas pero a las semanas pierden su efecto positivo.

Aunque no es muy frecuente que se den estos problemas, es conveniente realizar un seguimiento de los cambios durante unas semanas después de su implantación, para ver si realmente los cambios están teniendo el efecto esperado.

Por otro lado, es importante replantearse con cierta frecuencia los experimentos y cambios realizados hace tiempo. En circunstancias normales, lo que ha funcionado bien hoy, funcionará bien durante muchos meses (incluso años), pero eso no quiere decir que todo vaya a permanecer igual eternamente.

Por ejemplo, algo que ha funcionado bien durante años pueden dejar de funcionar por cambios en las estrategias de marketing, novedades tecnológicas, nuevos competidores, crisis económicas, cambios en el sector, etc. Por ello, es conveniente al menos una vez al año analizar todos los experimentos realizados en el pasado y plantearse cuáles podría ser conveniente volver a realizar en función de la nueva realidad del mercado

Instaura un proceso de mejora continua

El proceso de pruebas no se acaba con la primera mejora que consigas, sino que es recomendable seguir realizando pruebas sucesivas para seguir afinando y mejorar aún más los resultados. Es un proceso recurrente de mejora continua.

Por tanto, tan pronto como hayas terminado un experimento, tienes que plantearte cual va a ser el siguiente experimento que vas a poner en marcha. Si has conseguido una mejora importante, no lo marques como “optimizado” y lo metas en un cajón. Primero, plantéate cómo podrías aprovechar lo aprendido para mejorar aún más esa página o elemento.

Por ejemplo, si has conseguido la mejora introduciendo un testimonio de un cliente satisfecho, prueba a meter 3 o 4 testimonios más para ver si los resultados mejoran aún más.

Asimismo, plantéate cómo aplicar lo aprendido en otras áreas. Por ejemplo, si has mejorado la conversión de una página web introduciendo en el título un nuevo argumento de venta, prueba a introducir ese mismo argumento en tus anuncios online y offline, en emails, en folletos, etc.

Te recomendamos llevar un registro de todos los experimentos realizados (incluyendo pantallazos, estadísticas de resultados y comentarios relevantes), porque te ayudará a desarrollar conclusiones de lo que funciona y lo que no.

Herramientas para tests A/B

Los tests A/B se pueden aplicar no solo para webs sino para otros entornos como emails y anuncios. Por lo que general cada entorno requiere una herramienta específica:

Webs

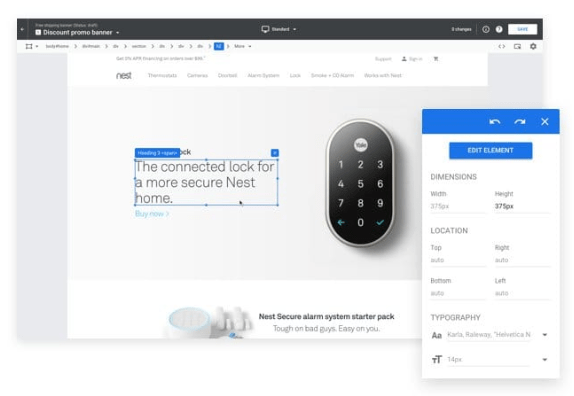

Para tests A/B en webs en general recomendamos Google Optimize porque tiene plan gratuito, integración sencilla con Google Analytics y es relativamente sencillo de utilizar. Hay otras herramientas similares o incluso superiores en algunos aspectos (pero de pago) como VWO y Optimizely.

Aparte de las soluciones que funcionan para cualquier web, hay plugins específicos para sistemas como WordPress que permiten hacer tests A/B de ciertas cuestiones (ej. https://wordpress.org/plugins/simple-page-tester/ y https://wordpress.org/plugins/nelio-ab-testing/).

También existen soluciones de código libre (open source) para realizar tests A/B sin ningún coste y sin compartir datos con ninguna empresa. Pero requieren conocimientos avanzados de programación y suelen dar menos garantías a nivel de funcionamiento, precisión, etc.

Emails

También se pueden realizar tests A/B de emails en herramientas de email marketing. La mayoría de herramientas ya tienen alguna función de este tipo, para comprobar por ejemplo con qué asunto consigue más aperturas y clicks.

Lo normal si estamos probando un email puntual es mandar el test A/B a una pequeña parte de la lista de destinatarios (un 20% por ejemplo) y luego mandar la versión ganadora al 80% restante. Cuantos más destinatarios/suscriptores metas en el test, más fiables serán los resultados, pero también más gente habrá visto la versión perdedora (la que da peores resultados).

Anuncios

Se pueden hacer fácilmente tests A/B de anuncios en Google Ads y Facebook Ads. Sus propios paneles de administración de anuncios ofrecen opciones para ello sin coste adicional.

Puedes consultar sus guías oficiales sobre como configurarlo:

Precauciones a la hora de elegir herramientas

La mayoría de herramientas comerciales son bastante fiables en su funcionamiento y los cálculos de resultados que ofrecen, pero si quieres asegurarte de la fiabilidad de una herramienta puedes empezar por realizar un test A/A.

Se trata de lanzar un test en el que las 2 versiones son exactamente iguales (por eso lo de “A/A” en vez de “A/B”) y por tanto deberían dar los mismos resultados.

Si tras dejarlo recabando datos bastante tiempo (mínimo 1 mes) el software te dice que hay un ganador claro (una diferencia de resultados significativa y fiable estadísticamente entre las 2 versiones), es que algo falla. O la herramienta no es fiable o hay un fallo de configuración o no tienes suficientes visitantes/conversiones para sacar conclusiones fiables en ese plazo.

Alternativas a tests A/B

Si tras hacer cálculos o tests reales has visto que no tienes suficiente tráfico y conversiones para hacer tests A/B fiables un un plazo razonable, es mejor que te concentres en otras formas de optimizar tu proceso de donación.

No serán tan fiables como un test A/B, pero es mejor que no probar posibles mejoras o realizar cambios según criterios subjetivos (sin datos que los respalden).

Básicamente hay 3 alternativas:

A) Céntrate en solucionar fallos claros

Se trata de revisar muy a fondo qué puede estar fallando en tu proceso de donación o qué podrías mejorar para aumentar donaciones.

Esto es importante siempre, pero si no puedes realizar tests A/B lo es aún más, porque no puedes probar muchas variantes fácilmente y comprobar resultados de manera fiable, así que tienes que recabar toda la información posible para centrar más el tiro y si es posible acertar a la primera en cualquier cambio que metas.

Si consigues detectar un fallo claro o mucha gente te dice que deberías mejorar un aspecto, no necesitarás realmente los tests A/B porque es casi seguro que mejorarás resultados al corregir ese aspecto.

Algunas fuentes de información útil son:

1) Datos de analítica web (Google Analytics, mapas de calor, grabaciones web…). Esto ya lo hemos cubierto con mucho detalle en el documento “Analítica web para aumentar donaciones“, así que no entraremos en ello, pero es una fuente de información clave para detectar posibles problemas en la web.

2) Encuestas a donantes, subscriptores y/o visitantes de la web. En especial puede ser interesante hacer encuestas a los usuarios que visitan la página de donación pero no acaban donando, para ver qué les puede estar echando para atrás. Se les puede preguntar cosas como “¿Tienes alguna duda o reparo a la hora de realizar la donación?” o “¿Deberíamos mejorar algo de esta página para ayudarte a donar más fácilmente”?. Se pueden utilizar herramientas como Hotjar para realizar fácilmente estas miniencuestas en la web.

3) Tests de usabilidad web. Se trata de ver cómo navegan personas reales por tu Web y que te cuenten qué problemas o dudas les van surgiendo. Se puede hacer de manera profesional (hay empresas especializadas en esto como Uxline en español o UserTesting en ingles) o simplemente pedirle a contactos tuyos que naveguen por tu web (o específicamente que intenten realizar una donación) y te vayan contando al mismo tiempo sus impresiones (si es posible en persona, ya que suele dar más información y aparte ves en directo cómo se mueven por la web). Debe hacerse con gente ajena a la organización, porque los usuarios que ya conocen una web bien suelen navegar de manera distinta al resto.

4) Revisar opiniones en busca de cosas que merezca la pena corregir o potenciar (reclamaciones, sugerencias y alabanzas recibidas en los últimos meses por parte de donantes o potenciales donantes). Pueden haber venido de emails, chats, llamadas, comentarios en redes sociales, eventos, etc. Y por supuesto hablar con todo el personal que tenga mucho trato de cara al público (también voluntarios), para ver si hay patrones que se repitan (quejas frecuentes, razones para decidirse a donar o no donar que mencionen mucho, contenidos o iniciativas que gusten mucho en general…).

B) Prueba cambios sin tests A/B

Si no tienes claro el efecto que tendrá un cambio pero tampoco tienes suficiente volumen para realizar tests A/B fiables, la solución más sencilla es simplemente meter el cambio y esperar a ver resultados.

Esta es una buena opción si tu organización tiene resultados estables (no varían mucho los resultados/donaciones entre distintas semanas/meses) y si no estás metiendo otros cambios al mismo tiempo. En ese caso, es razonable suponer que si metes un cambio y ves una mejora significativa de resultados que se mantiene durante varias semanas, es ese cambio el causante de la mejora.

Es la opción más sencilla de todas, porque no tienes que complicarte configurando tests A/B.

Sin embargo, si en tu organización los resultados son inestables (varían mucho entre distintos períodos aunque no se metan cambios) o estáis metiendo muchos cambios a la vez (modificaciones en la web, nuevas campañas promocionales, etc.) este sistema puede llevarte a engaño. Puede que metas el cambio y mejoren los resultados, pero esa mejora no se deba al cambio metido sino a otros factores. Los tests A/B sirven precisamente para evitar que esos otros factores “contaminen” los resultados y nos hagan sacar conclusiones erróneas (confundiendo correlación con causalidad).

Para esos casos, recomendamos la siguiente opción:

C) Realiza tests A/B con limitaciones

Normalmente se recomienda realizar tests A/B que alcancen un 95% mínimo de confianza estadística y algunas herramientas de hecho no dan un ganador hasta que se alcanza ese nivel. Ese 95% que significa que tenemos un 5% de posibilidades de equivocarnos (es decir, de estar dando como ganador del test una versión que realmente no es mejor que la otra e incluso puede ser peor).

No obstante, ese es un nivel arbitrario. Si no tenemos suficiente tráfico para llegar a ese 95% en un plazo razonable, podríamos conformarnos con un 90% o incluso un 80% de confianza estadística (que requiere bastante menos volumen y tiempo). Estaríamos arriesgándonos más a equivocarnos, pero en realidad seguiría siendo menos “arriesgado” que la otra opción principal (meter cambios sin datos fiables de qué impacto han tenido).

Otra alternativa (complementaria) es cambiar el objetivo que tomamos como referencia para el test A/B, buscando objetivos/conversiones que tengan más volumen. Por ejemplo, si tenemos pocas donaciones completadas pero muchos clicks en los botones de donar, podríamos fijar los clicks en esos botones como el objetivo principal del test A/B. Así tendríamos más volumen de conversiones y podríamos realizar tests A/B con resultados estadísticamente fiables en menos tiempo. Obviamente esto es menos preciso porque que hagan click en el botón de donar no implica que acaben donando, pero si las donaciones totales suben también, podemos suponer que es un cambio beneficioso sin un gran riesgo de equivocarnos.

La última alternativa que vamos a comentar aquí es realizar tests en otras plataformas que nos aporten más audiencia y/o más volumen de datos. Por ejemplo, podemos hacer tests con diferentes anuncios en Facebook o Google (probando diferentes textos, fotos, vídeos…) y ver cuáles nos traen más clicks (CTR), donaciones, etc. Lo que funcione mejor en Facebook o Google no es necesariamente lo que funcionará mejor en otros medios (nuestra web, nuestros mailings…), pero si no tenemos volumen para hacer tests A/B con nuestra propia audiencia, al menos así podremos evaluar qué argumentos o elementos visuales tienen más tirón en general.